Author

Marc Zollingkoffer

Director Software Engineering

bei SYZYGY Techsolutions

Lesedauer

8 Minuten

Publiziert

01. Dezember 2023

Nachdem 2023 vom AI-Hype dominiert wurde, wollen wir zum Jahresausklang zurückblicken und eine Zwischenbilanz ziehen. Was ist von dem Hype bei SYZYGY Techsolutions bereits in der Substanz, also der täglichen Arbeit angekommen und wie wird unsere Arbeitsweise nachhaltig geprägt? Wie haben sich die Anforderungen an unsere Entwickler verändert und was können wir für die Zukunft prognostizieren? Eine Bestandsaufnahme und Spekulation.

Ehrlicherweise ist AI als inhärenter Baustein – damit meine ich, dass AI-Modelle im Produkt selbst eine tragende funktionale Rolle erfüllen – für unsere Kundenlösungen noch nicht in der Breite angekommen. Es dominieren nach wie vor Produkte aus klassischem UX und Design, die mit den üblichen Tech-Stacks, Frameworks und Plattformen umgesetzt werden. Dass sich das bald ändern wird, davon ist jedoch auszugehen.

Pragmatischer Weise haben wir uns daher dieses Jahr erst einmal weniger um das „Was“, sondern vielmehr um das „Wie“ gekümmert und damit AI auf den Weg gebracht, indirekt auf unsere Produkte zu wirken, indem nämlich die Produktentwicklung zunehmend gestützt auf AI-Tools erfolgt.

Wir haben uns also darauf fokussiert, unseren Entwicklern AI gestützte Tools für ihre Arbeit an die Hand zu geben. Im Rahmen eines STS-Camps haben wir uns zuallererst spielerisch dem Thema angenähert. Mehrere Teams mussten eine komplexe Entwicklungsaufgabe mit Hilfe von AI lösen.

Ein paar Tools bereitstellen klingt auf den ersten Blick recht einfach. Aber, für uns als Dienstleister, der im Wesentlichen mit Code und Daten arbeitet, die uns anvertraut wurden und uns nicht selbst gehören, ist hohe Sorgfalt angebracht. Denn diese werden mitunter mit der AI geteilt und es muss sichergestellt werden, dass sie zum Beispiel nicht für Trainings derselben verwendet werden. Einige organisatorische Hürden mussten also zuerst überwunden werden:

- Fragen des Datenschutzes

- Schutz von Firmengeheimnissen und intellektuellem Eigentum

- Sicherheitsanforderungen

- Wahrung des Urheberrechts

- Ethische Aspekte

Diesen Themen begegnen wir mit unserer SYZYGY AI-Policy und haben damit die Grundlage gelegt, dass wir nun GitHub Copilot Enterprise und Bing Enterprise Chat (unter der Haube ein GPT-4 Modell) flächendeckend zur Verfügung stellen können.

Mit Blick auf das Tooling erwarten wir einen stetigen Fortschritt. Sollten diese Erwartung eintreten, dann wird sich unsere Arbeit zunächst graduell und letztendlich fundamental verändern.

Zukunft der Applikationsentwicklung mit AI

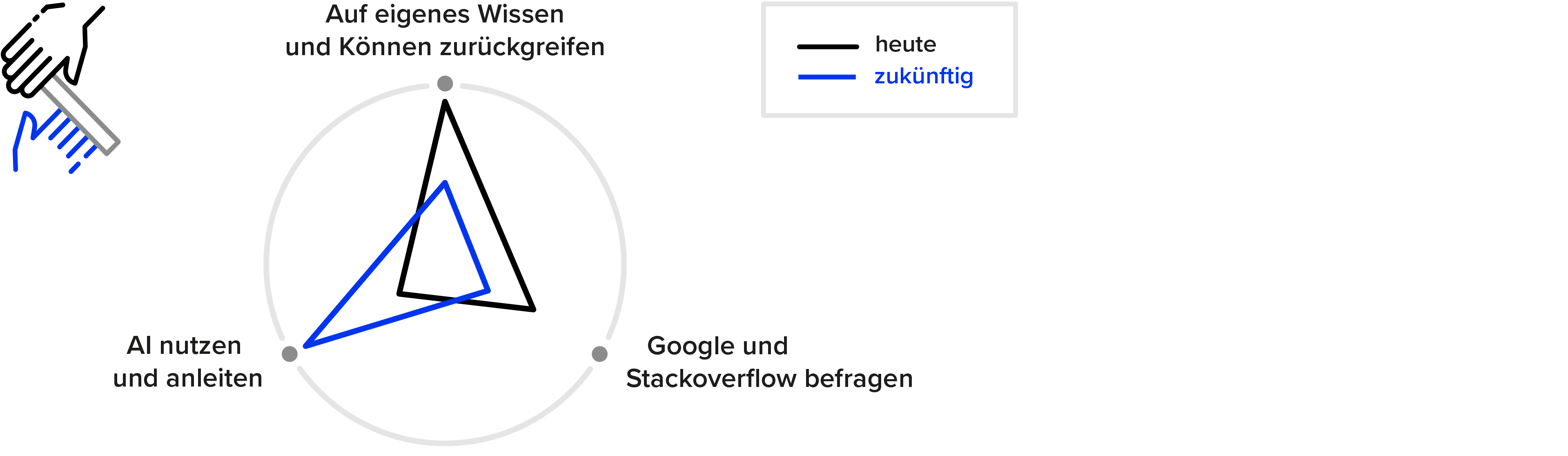

Im “Now” gilt noch mehr als bisher: Keine Angst vor neuen Sprachen und Frameworks. Mit der Hilfe der Copiloten kann man nun noch schneller als bisher mit Google und stackoverflow in eine Technologie einsteigen. Die Basis bleibt dabei selbstverständlich solides Wissen und Können in der Softwareentwicklung. Nur so können Vorschläge der AI vernünftig bewertet und orchestriert werden. Aber, coden im Sinne von Programmieren wird “Probable” immer weniger der zentrale Bestandteil des Entwicklungsprozesses. Denn programmieren kann mit zunehmender Qualität die AI selbst. Dabei muss sie aber sicher und sinnvoll angewiesen und beaufsichtig werden.

Denn, eine Lösung nach der Anforderung des Kunden aus den verfügbaren Lösungsbausteinen zu konzipieren und herzustellen – das wird AI bis auf weiteres nicht vollständig selbständig leisten können.

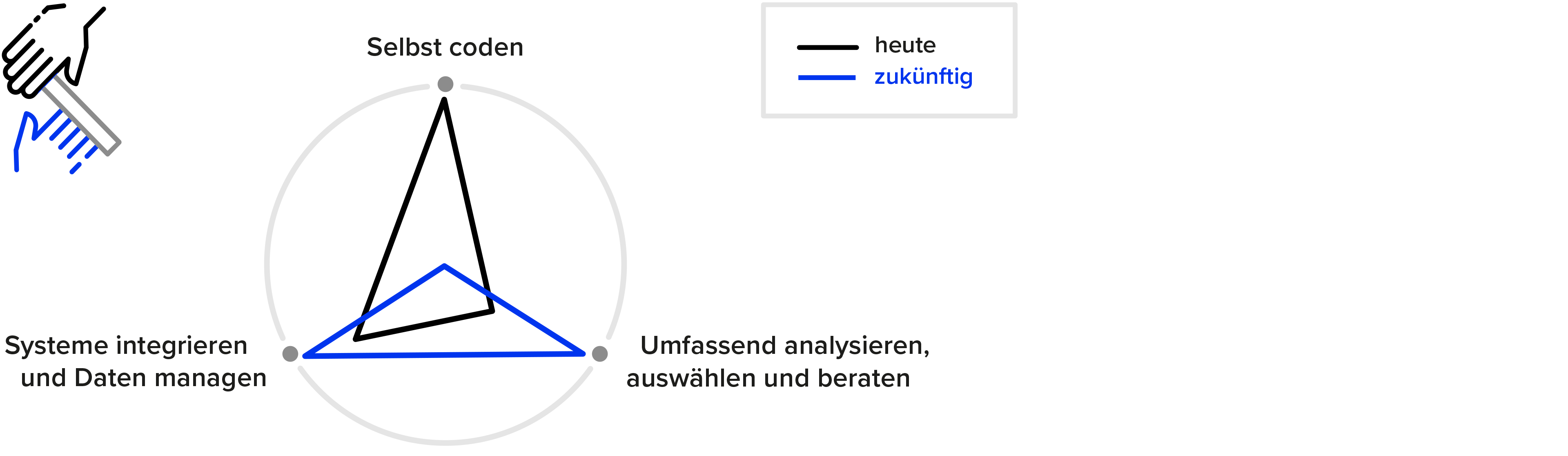

Welche Produkte und Plattformen setzen wir ein? Wie integrieren wir neue Bausteine mit existierenden Legacy-Applikationen? Wie werden Daten erfasst, gespeichert und zugänglich gemacht und nicht zuletzt, wie können diese Daten für das Training und die Auswertung durch AI-Modelle bereitgestellt werden? Aspekte der allgemeinen Enterprise Readiness wie Security, Informationssicherheit, Datenschutz, Vendor-Lock-Ins und viele mehr sind dabei stets zu betrachten und für den Anwendungsfall wirtschaftlich angemessen einzubetten. Der Weg vom Coder zum Solution Architekt hat also gerade erst begonnen.

Aber nicht nur das „Wie“ wir arbeiten sondern auch das „Was“ wird sich verändern. Aktuelle digitale Produkte und Lösungen sollen im Wesentlichen Menschen vor einem Bildschirm befähigen, Informationen zielgenau aufzufinden und unterschiedlichste Aufgaben zu erledigen. Zum Beispiel die Recherche nach einem neuen, passenden Auto und der Buchung einer Probefahrt. Hierzu werden Suchmaschinen und die Website oder App der jeweiligen Autohersteller genutzt. Unser Geschäft besteht im Kern nun darin, den Hersteller zu befähigen, solche Customer-Journeys und Prozesse abzubilden. Dazu erschaffen wir Mittel, um Inhalte zu erstellen, damit diese in Suchmaschinen gefunden werden. Wir implementieren Applikationen mit effizienter Benutzerführung, so dass Conversions wie eine Probefahrt in die Wege geleitet werden können. Unter dem Strich erstellen wir also Werkzeuge für Unternehmen und ihre Kunden, die für beide Seiten einen Nutzen stiften.

Denkt man aber die sich abzeichnenden Fähigkeiten von AI-Modellen weiter, hin zu persönlichen Assistenten, die in der Lage sind mittels natürlicher Sprache zu interagieren und die Absichten ihrer Nutzer zu verstehen, so könnten sich in einer „Fantastic“ Welt der AI-Agenten, viele der Werkzeuge wie Marketing-Content, Webseiten oder Konfiguratoren, mit denen wir uns heute schwerpunktmäßig beschäftigen, stark verändert darstellen. Die Tools verschwinden, da der Assistent nun die „Arbeit macht“. Dabei muss man sich vorstellen, dass womöglich nicht nur ein Assistent zum Einsatz kommt, sondern dass dieser wiederum ein Netzwerk aus AI-Agenten nutzt, um zusammen mit diesen, das Bedürfnis seines Nutzers zu befriedigen. Oben beschriebenes Auto-Recherche-Szenario könnte dann wie folgt ablaufen.

The Fantastic – Das zukünftige Interface eines Autoherstellers 2033

MENSCH: Ich denke, ich werde mir ein neues Auto anschaffen. Mehr als 40.000€ soll es aber auf keinen Fall kosten. Ich will einen Neuwagen.

ASSISTENT(AI): OK. Aktuell gibt es da mehrere Optionen. Besonders interessant wäre, wegen des guten Preis-Leistungs-Verhältnisses, der neue Mazda 300.

[Der Assistent verwendet ein API zur Abfrage von Modellspezifikationen, Preisen, etc. Darunter liegt ein entsprechender Datenhaushalt für performanten und akkuraten Zugriff]

MENSCH: Zeig mal her.

ASSISTENT(AI): Hier sind einige Bilder des Mazda 300.

[Der Assistent nutzt einen Medien-Pool mit getaggten Bildern für den schnellen und gezielten Zugriff. Eine narrow AI, die mit den Modellen der Marke trainiert wurde, hat den Medien-Pool entsprechend vorbereitet]

MENSCH: Nicht schlecht. Bitte mal näher von vorne und auch als Innenansichten.

ASSISTENT(AI): Hier ist der Mazda 300 von vorne und eine 360° Ansicht des Innenraums.

MENSCH: Bitte in den Innenraum gehen. … Ok, nach links, runter. Jetzt das Cockpit…. Was ist das dort für eine Anzeige in der Mitte.

ASSISTENT(AI): Das ist die Distanz bis zu nächsten Lademöglichkeit. Sie ist grün, da in Reichweite.

[Der Assistent verwendet eine 360°-UI-Komponente mit einem Interface, so dass die Ansicht über Sprachbefehle gesteuert werden kann. Bild- und Objekterkennung erfolgt mittels speziell trainierter narrow AI auf Basis von detaillierten Fahrzeuginformationen wie Bordhandbuch und FAQs]

MENSCH: Perfekt, nur die Felgen gefallen mir nicht.

ASSISTENT(AI): Hier sind weitere Optionen für die Räder.

MENSCH: OK, ich nehme die in der Mitte.

ASSISTENT(AI): Ich habe die vorherigen Bilder mit den neuen Felgen angepasst.

[Der Assistent verwendet eine narrow AI zur Manipulation von Bildern on-the-fly.]

MENSCH: Danke. Ich möchte gerne eine Probefahrt machen.

ASSISTENT(AI): Es gibt 2 Händler in der Nähe. Bei welchem soll ich anfragen?

MENSCH: Egal. Aber es sollte am Dienstagvormittag sein.

ASSISTENT(AI): Ich habe eine Probefahrt bei Auto Müller in Entenhausen für nächsten Dienstag um 10:30 gebucht. Dein Navi ist entsprechend vorbereitet und der Termin in deinem Kalender vermerkt.

[Der Assistent nutzt die Händlersuche. Mit einer AI-to-AI-Interaktion, mit dem Outlook-Copilot des gwählten Händlers wird der Probefahrttermin angestimmt und gebucht]

Wir sprechen hier natürlich von einer Utopie, die noch längst nicht Wirklichkeit geworden ist. Ob diese jemals so eintreten wird, hängt nicht nur allein davon ab, ob sich der technische Trend tatsächlich so fortschreiben lässt, sondern auch zum Beispiel an der Frage, ob Energie- und Compute-Kosten es jemals erlauben werden, solche rechenintensiven Szenarien in voller Skalierung wirtschaftlich sinnvoll abzubilden? Nicht alles, was mit AI gelöst werden kann, muss und wird auch mit AI gelöst werden. Ganz normale Software wird vermutlich aus Effizienzgründen weiter ihren Platz haben. Auf jeden Fall aber sehen wir hier ein hochkomplexes System aus AI und klassischen Services dessen Möglichkeiten weit über das hinausgehen, was wir heute so an Anwendungen kennen. Diese gesteigerte Komplexität gilt es zu beherrschen. Das wird dann in einer solchen Zukunft eine unserer wesentlichen Aufgaben sein.

Head of Technology